Los transformers han sido los reyes indiscutibles durante los últimos años. Modelos como GPT, Llama, Gemini o Claude han demostrado su potencia generando texto, código, audio e incluso imágenes.

Pero en paralelo está emergiendo una nueva familia de modelos: los modelos flow, también conocidos como flow matching models o, en su variante más reciente, Flux. Estos modelos prometen algo revolucionario: generar datos completos en un solo paso, con más control global y menos latencia.

Hoy vamos a explorar cómo funcionan ambos enfoques, sus diferencias fundamentales y cuándo puede tener sentido elegir uno u otro. Porque no se trata de sustituir, sino de ampliar el arsenal de herramientas para distintos problemas.

1. Transformers: los narradores token a token

Los transformers son como un narrador que escribe una historia palabra a palabra. Su funcionamiento es discreto y secuencial, ideal para trabajar con texto y secuencias bien definidas.

Pipeline típico de un transformer:

-

Vectorización (embedding): convertir tokens en vectores densos.

-

Positional encoding: añadir información sobre la posición, ya que el modelo no tiene noción de orden por sí mismo.

-

Capas de atención (self-attention): cada token «mira» a los demás para entender el contexto.

-

Feed-forward network: pequeñas redes que mezclan y transforman la información.

-

Stack repetido: se apilan múltiples capas como pisos de un edificio.

-

Decodificación autoregresiva: se genera un token, se añade a la secuencia y se repite el proceso.

Ventajas:

-

Perfectos para texto y tareas secuenciales.

-

Ecosistema maduro con librerías optimizadas.

-

Capaces de aprender relaciones complejas entre elementos.

Limitaciones:

-

Latencia alta: para secuencias largas, la generación puede ser lenta.

-

Errores acumulativos: si un token falla, todo lo que viene detrás se ve afectado.

-

Falta de visión global: cada predicción depende solo del pasado, no del resultado final deseado.

Tip avanzado: si trabajas con transformers para texto largo, explora técnicas como speculative decoding o parallel decoding. Pueden reducir drásticamente el tiempo de generación sin necesidad de cambiar el modelo base.

2. Flow y Flux: generación como un proceso continuo

Los modelos flow parten de una idea distinta. En lugar de generar un elemento a la vez, modelan directamente la transformación completa desde ruido hasta dato coherente.

Imagina que empiezas con una nube de puntos caótica y poco a poco la moldeas hasta que se convierte en una imagen, un sonido o incluso un estado de mundo. Este proceso es continuo, como el flujo de un río, en lugar de discreto como los pasos de una receta.

Cómo funciona:

-

Estado inicial: ruido puro, como un lienzo en blanco con píxeles aleatorios.

-

Campo de flujo (

f(x, t)): el modelo aprende una función que define cómo moverse en el tiempo desde ese ruido hasta el dato final. -

Integración continua: se simula el proceso de transformación resolviendo una ecuación diferencial, como si siguieras la corriente de un río.

-

Condicionamiento global: se pueden aplicar condiciones en cualquier punto del proceso, por ejemplo, un prompt de texto que describa la imagen a generar.

-

Resultado en uno o pocos pasos: la generación no necesita miles de iteraciones, puede hacerse de golpe.

Esto recuerda a los modelos de difusión (como Stable Diffusion), pero con una diferencia clave: los flow son deterministas y continuos, mientras que la difusión es discreta y estocástica.

Tip práctico: si trabajas con imágenes o audio, los modelos flow pueden ser mucho más rápidos que los de difusión clásicos. Además, suelen ser más fáciles de controlar cuando necesitas coherencia global.

3. Comparativa directa

| Característica | Transformers (GPT, Llama…) | Flow / Flux (Flux, Stable Diffusion Next-Gen) |

|---|---|---|

| Generación | Secuencial, token a token | Global y continua |

| Latencia | Alta en secuencias largas | Muy baja, incluso en un solo paso |

| Control global | Difícil, errores acumulativos | Más sencillo, estructura consistente |

| Dominios típicos | Texto, chat, código | Imágenes, vídeo, música, simulaciones |

| Filosofía | Narrador improvisando | Escultor moldeando una pieza entera |

Tip básico: no pienses en esto como una guerra de arquitecturas. En muchos proyectos se combinan ambos enfoques:

Transformer para comprender texto e instrucciones.

Flow para generar contenido visual o multimodal.

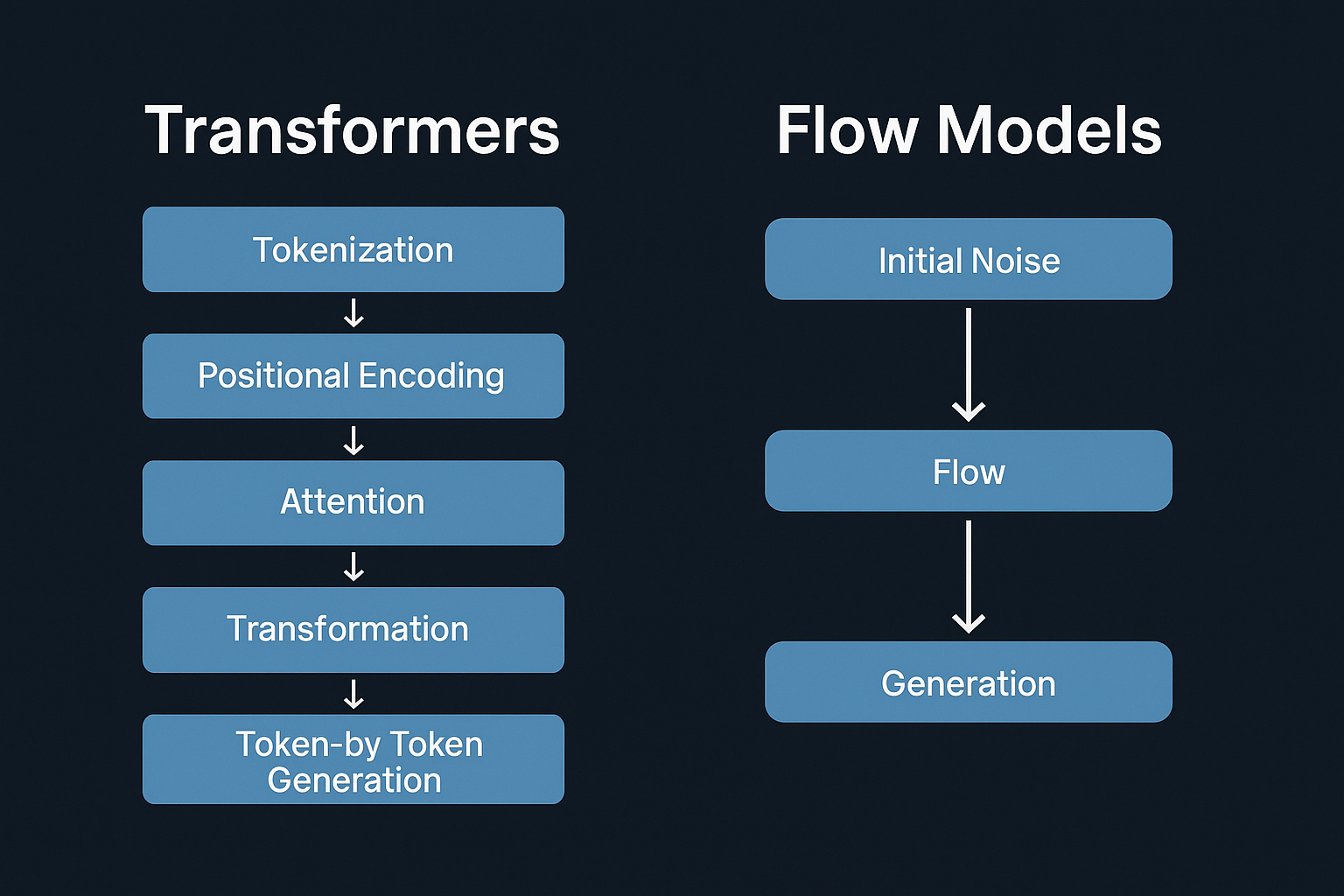

4. El pipeline de un flow vs. un transformer

La diferencia se entiende mejor si los vemos como diagramas mentales:

Transformer:

-

Token → embedding

-

Positional encoding

-

Self-attention → feed-forward

-

Repetir N veces

-

Generar token siguiente

Cada paso es discreto y depende de los anteriores.

Flow:

-

Ruido inicial

-

Aplicar el campo

f(x, t)a lo largo de un tiempo continuo -

Resultado final emerge de golpe

Aquí no hay pasos separados, sino un proceso fluido, como animar una simulación física.

Tip intermedio: si vienes del mundo de las simulaciones físicas (gráficos por ordenador, fluidos, física de partículas), los modelos flow te resultarán conceptualmente familiares. Básicamente están aprendiendo una función de dinámica de sistemas.

5. Implicaciones para world models

En The Black Box Lab llevamos tiempo investigando world models, modelos que no solo generan datos, sino que simulan un mundo interno coherente. Aquí la elección entre transformers y flow es crucial:

-

Transformers:

Ideales para describir secuencias de eventos: diálogos, acciones, cambios discretos.

Piensa en un videojuego como una narración paso a paso. -

Flow:

Perfectos para simular procesos continuos: físicas, estados globales, mundos persistentes.

Como un motor de física que evoluciona en tiempo real.

La combinación de ambos puede ser muy poderosa. Un transformer puede entender el «guion» de la historia, mientras que un flow genera los detalles de la escena en coherencia con ese guion.

Tip avanzado: en proyectos complejos, usa transformers para tareas de high-level planning y flows para low-level generation.

Ejemplo: un robot que primero planifica una acción con un transformer y luego genera el movimiento físico con un flow.

6. Futuro: hacia modelos híbridos

El panorama actual apunta hacia la convergencia. Cada vez veremos más modelos híbridos que mezclan:

-

La capacidad de los transformers para comprender y razonar.

-

La potencia de los flows para generar de forma global y rápida.

Esto podría revolucionar campos como:

-

Videojuegos generativos: mundos creados en tiempo real.

-

Gemelos digitales industriales: simulaciones precisas y rápidas.

-

IA multimodal: texto, imagen, sonido y acción en un solo modelo.

Tip estratégico: si estás diseñando un roadmap de I+D, empieza explorando transformers (por su madurez y herramientas disponibles) y reserva un espacio para prototipos con flows.

En 2026-2027 veremos flows mucho más accesibles y con librerías maduras.

¿Quieres implementar un modelo de IA en tu negocio? Contacta con nosotros.

Deja una respuesta